Здравствуйте, уважаемые читатели!

В этой статье я хочу рассказать Вам, как проверить индексацию сайта в поисковых системах Google и Яндекс. В индекс поисковиков попадают те страницы, которые про сканированы ее роботами и внесены в ее базу данных. Базу поисковых систем называют - индекс, а сам процесс сканирования и внесения новых страниц сайта - индексацией.

Проверить сколько страниц находится в индексе Яндекса или Гугла можно вручную, использовав специальные операторы, о которых я подробнее напишу ниже, а также при помощи специальных сервисов.

Как проверить индексацию сайта в Яндекс

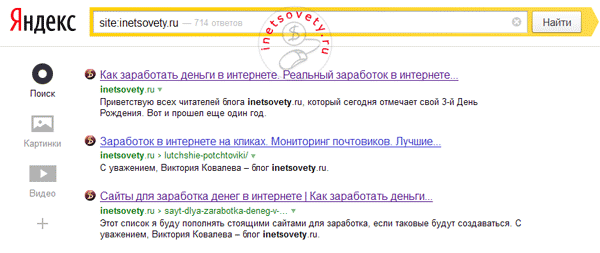

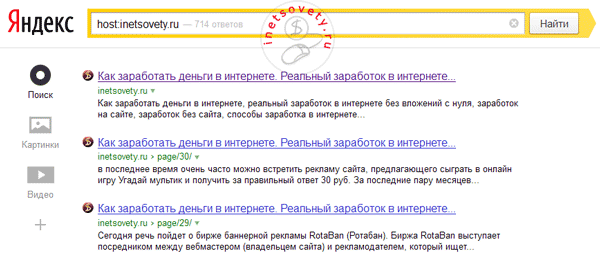

Операторы host и site покажут сколько страниц сайта проиндексировано Яндексом. Отличие между host и site заключается в следующем: host - показывает количество проиндексированных документов с данного домена и его поддоменов, а site - покажет сколько страниц Вашего сайта попало в индекс Яндекса.

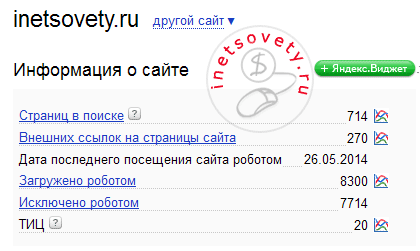

Результат проверки индексации моего сайта Яндексом смотрите на картинках ниже:

Результат с оператором host ничем не отличается от представленного выше, поскольку индексация документом для моего домена запрещена в файле robots.txt, а поддоменов я не создавала.

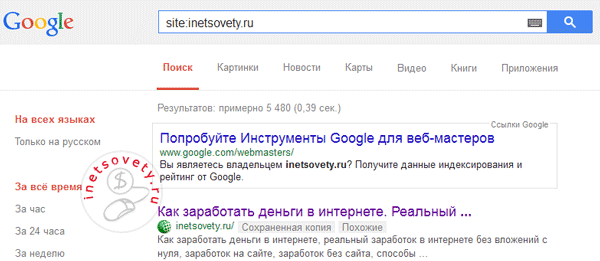

Проверка индексации страниц сайта в Google

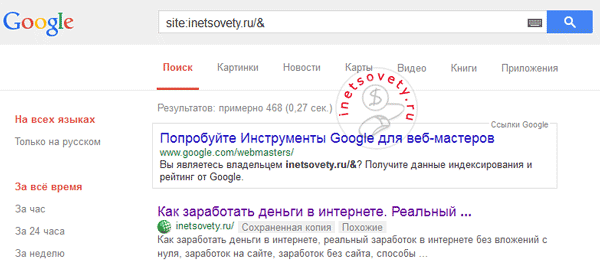

В Google работает только один оператор site, показывающий число проиндексированных страниц. Отличие Гугла от Яндекса заключается в том, что у Google есть основной и дополнительный индекс. Что каждый из них представляет читайте ниже.

Дополнительный индекс Google. Сеошники дали ему название "сопли", так как в нем находятся все страницы и документы, которые роботу Google удалось найти на Вашем сайте. Сюда можно отнести страницы сайта, которые запрещены для показа в основной выдаче: это могут быть дублирующие страницы сайта, которые создаются из-за новых комментариев, страницы постраничной навигации.

Основной индекс Google. В нем находятся все проиндексированные страницы Вашего сайта, которые показываются пользователям интернета в результатах выдачи по искомым ключевым фразам. Чтобы определить какие страницы сайта попали в основной индекс, добавьте к оператору символ &, как показано на картинке ниже. Символ & находится на клавиатуре на кнопке с цифрой 7.

На первой картинке показано 5 480 результатов, а на второй - 468. По своей неопытности, я сразу после создания своего блога не закрыла от индексации ненужные разделы в файле robots.txt. В то время, когда я создавала блог информации было не много на тему создания сайтов, приходилось все делать "методом проб и ошибок". Это сейчас уже и готовые примеры файла robots.txt есть в сети и рекомендации по его настройке. Поэтому мусорных страниц, которые не несут никакой информации и пользы, Гугл успел насобирать до 5 000 штук.

Полную картину того, какая индексация сайта в поисковых системах, именно у Вашего сайта покажет панель инструментов для веб-мастеров Яндекса и Гугла. Если Вы еще не подключили сайта ни к одной из этих панелей, скорее сделайте это. Помогут Вам в этом эти статьи-инструкции:

- Инструменты Google Tools https://inetsovety.ru/google-search-console/

- Яндекс Вебмастер https://inetsovety.ru/yandex-webmaster/

В инструментах Гугла в пункте Индекс Google, Вам будет показан график с изменением количества страниц по датам. Главное, чтобы он был ровным, а не такой, как у меня :):

На главной странице Яндекс Вебмастера, Вы увидите численное значение проиндексированных страниц, а кликнув по значку графика напротив строки "Страниц в поиске", сможете посмотреть график за последние 3 месяца.  А самый простой способ проверить индексацию сайта и посмотреть какое количество страниц в индексе Яндекса и Гугла - воспользоваться одним из следующих бесплатных сервисов:

А самый простой способ проверить индексацию сайта и посмотреть какое количество страниц в индексе Яндекса и Гугла - воспользоваться одним из следующих бесплатных сервисов:

- плагин RDS bar. Устанавливается, как дополнение, для любого браузера. И позволяет в несколько кликов посмотреть информацию по основным параметрам для любого сайта.

- инструменты для вебмастера . В этом сервисе мне больше всего нравится графическое представление статистики по изменению показателей сайта и по индексации сайта в Яндексе и Гугле

На этом у меня все. Если возникли вопросы по теме, спрашивайте в комментариях. До встречи!

Кстати нашел ошибку на всех блогах в Robots.txt очень сильно влияет на индексацию. Убрал на своем блоге и индексация пошла в гору

Я уже давненько заметила, что роботу Гугла наплевать на директивы в Robots.txt, он сканирует все страницы, на которые попадает.

Сканирует абсолютно все, но мне пока не совсем понятно, что и как влияет на ранжирование.

Даже закрытые от индексации директории все равно индексируют только вносят в запрет от поиска так сказать делают такие страницы как страницы сопли. Тоже ничего хорошего нет от этого.

Согласен. Есть такое. В выдаче часто меньше трети проиндексированных страниц.

Остается разобраться, почему индексирует, но потом исключает страницы из индекса, при этом явных признаков наложения фильтра нет, так как все равно достаточно много страниц выводится в поиске и иногда на первых позициях по ВК запросам.

Вот и я заметил это. А в яндекс попадают все и исключаются из поиска. Потом сделать корректировку роботса и работа по сканированию сайта пошло в норму. Но пока наблюдаю только не делюсь не с кем чтобы не навредить вдруг не все гладко с индексацией.

Я пока с Яндексом настолько не заморачивался. Пока устраивает трафик с Гугла — вложенные время и средства вполне оправдывает. С Яндекса трафик тоже есть, но в меньших объемах.

С яндексом разбираться роще голову сломать. с их алгоритмами всегда заморочки

Оптимально, конечно, будет, если трафик будет расти с обоих ПС, но если этого достичь не удается, то я бы сделал акцент на той поисковой системе, которая лучше ранжирует сайт и дает больше трафика.

У меня тоже страницы сопли в большом количестве а что от них зависит не знаю. вредят или нет?

Вроде как особого вреда не наносят.

Сегодня узнал что вред от этого большой. Страницы сопли это дублированный контент и ничего хорошего не светит от этого

Гугл и Яндекс такие страницы по-разному воспринимает. У создателей Яндекса другой алгоритм и другие интересы. Соответственно и подход другой.

Согласен Сопли больше всего не любит гугл

Но даже Яндекс иногда номально ранжирует такой контент, если он выводится по-разному в адресной строке с одного сайта за счет разных адресов ссылок. Во всяком случае трафик дает.

Хотя если посмотреть то можно найти альтернативу RDS бару, например PR-CY, так же встраивается как дополнение для браузера. Ничем не хуже

Решений всегда много. Главное чтоб помогали достигнуть цели.

Да цели это главное

RDS бар чем удобен, что необходимую информацию можно вывести в панель браузера и при этом дополнительно никуда заходить не нужно.

Я в основном только им и пользуюсь. Мне очень нравиться и полученной информации вполне хватает

Вся необходимая информация выводится одним кликом мышки и достаточно быстро.

Я в свое время сколько о нем читал, но никак руки не доходили поставить Видимо в тот момент еще не настолько увлекся данной темой.

Видимо в тот момент еще не настолько увлекся данной темой.

Вот такой вопрос появился ко всем. Почему все закрывают рубрики на блоге от индексации? Ведь в рубриках собирается достаточно хороший вес с которым можно продвигать сч запросы. Никто об этом не думал?

Я ничего не закрываю и в роботс тоже не лажу. Многие манипуляции с роботс уже бессмысленны.

Да сейчас все стало намного иначе чем раньше. Поисковики стали умнее и лазейки к ним пока нет так как нет нормальной информации

Все меняется. Раньше с помощью роботс пытались злоупотреблять оптимизацией. А сейчас нужно подавать качественный контент, а все остальные методы SEO имеют значительно меньший вес, а некоторые из них даже вредят.

Если лазейки есть, то нашедшие их не поделятся информацией, пока эта лазейка будет приносить доход. Начнут делиться только тогда. когда доход будет минимальным и то, делиться будут на платной основе. Дойную корову просто так и задешево не продадут.

У меня страницы залетают в индекс примерно через 2-5 минут после публикации. Проверяю РДС баром

Гугл индексирует достаточно быстро. Яндекс немного дольше.

Да яндекс временами даже очень тормозит. гугл успевает проиндексировать все в доль и поперек. А яндекс только начинает шевелится

Вот так вот у Яндекса работает алгоритм. Уверен, они по своим определенным причинам медленнее добавляют страницы в индекс.

Да я тоже так считаю. Какие нибудь песочницы ввели или просто не хватает мощностей чтобы индексировать со скоростью гугла

Мощностей у них явно меньше, чем у Гугла и страницы в выдачу постепенно заходят, хотя индексируются достаточно быстро после добавления в Оригинальные тексты.

Я тоже всегда пользуюсь сервисом pr-cy, но иногда он может глючить, поэтому приходиться проверять напрямую, статья вполне актуальна.

Я раньше пользовался pr-cy, пока не узнал о РДС баре. Сейчас мне его вполне хватает.

Можно так же использовать программку Сайт аудитор. Бесплатная и показывает все очень точно.

Альтернатив RDS и Сайт аудитору достаточно. Каждый выбирает сам, что для него более удобно.

Возможно, но мне нравятся больше всего сайт аудитор и RDS bar

Для анализа лучше использовать разные сервисы, так как работу алгоритмов поисковых систем знают только их создатели.

Спс, Виктория, я проверяю через РДС бар)).

Я тоже пользуюсь RDS bar, но почему то не всегда показывает правильное количество проиндексированных страниц. При проверке сайта через программу сайт аудитор есть небольшая разница

Результаты могут отличаться от разного периода сканирования. Иногда сервис может выдавать устаревшую информацию, если сайт на нем сканировался ранее.

Да я тоже это замечал, осле повторной проверке показатели становятся одинаковыми

Некоторые сервисы для повторной проверки предлагают зарегистрироваться, иначе не выдадут новую информацию.

У меня проблема с индексацией в яндексе, в чем могут быть причины не знаю

Страницы совсем не индексируются или индексируются плохо? Может robots.txt нужно поправить? У Виктории на блоге можно скачать готовый robots.txt, котором нужно прописать адрес своего сайта и все.

Вопрос у Олега не очень понятен. Возможно сайт с самого начала не индексируется а возможно перестал индексироватся. Причины разные. Может попробовать кросспостинг в соцсети или накрутка твитов. Иногда помогает

Как вариант. Настройка кросспостинга сэкономит много времени. Нужно только изначально выделить несколько минут.

Яндекс позже начинает индексировать и медленнее.

Яндекс не успевает за гуглом, да и никогда не успеет

Ага. Яндекс локален, а Гугл по всему миру. Даже с Рамблером, Мейл.ру, Квипом и всеми остальными вместе взятыми не догонят Гугл.

Какой вред «сопли» наносят сайту? Обязательно закрывать эти страницы от индексации?

У Вас две опечатки:

— в первом предложении в фразе

— над ссылками на инструменты Гугла и Яндекса